千万QPS毫秒响应 快手数据中台建设中的数据处理服务实践

在短视频与直播行业迅猛发展的浪潮中,快手作为领先的内容社区,面临着海量用户行为数据实时处理与分析的巨大挑战。为支撑业务的飞速创新与增长,快手构建了以“千万级每秒查询率(QPS)与毫秒级响应”为核心目标的数据中台,其数据处理服务实践成为了业界关注的焦点。

一、 核心挑战与架构目标

快手的数据洪流主要源自视频播放、互动、社交、直播打赏等场景,其特点在于数据量极大、产生速度极快、且业务对数据新鲜度与查询性能要求极高。传统批处理与高延迟的查询架构已无法满足推荐系统实时调控、风控即时决策、运营实时洞察等需求。因此,快手数据中台的建设确立了明确目标:构建一个能够稳定处理每秒千万级请求,并在复杂查询下实现毫秒级响应的统一数据处理与服务层。

二、 数据处理服务的核心架构实践

为实现上述目标,快手的数据处理服务采用了分层、融合的技术架构:

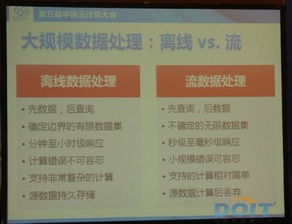

- 流批一体的数据摄入与计算层:采用Apache Flink作为核心计算引擎,统一处理实时流数据与微批数据。通过定制化优化Flink的状态管理、网络传输与Exactly-Once语义保证,使其能够高效处理每秒数十亿条的消息流,为下游提供低延迟(百毫秒级)的实时数据快照与聚合结果。与离线计算链路打通,确保数据口径的一致性与灵活性。

- 高性能分布式存储与查询引擎:针对不同的数据访问模式,混合选用多种存储与查询技术。

- 对于需要极低延迟点查(如用户画像实时查询),深度优化了分布式键值(KV)存储系统,结合智能缓存、内存池化与RDMA网络技术,将P99延迟压至毫秒级。

- 对于复杂的即席查询与多维分析,则基于Apache Doris或ClickHouse等MPP数据库构建实时数仓,通过预聚合、智能索引、数据分层(热温冷)等手段,在万亿数据规模下实现亚秒级响应。

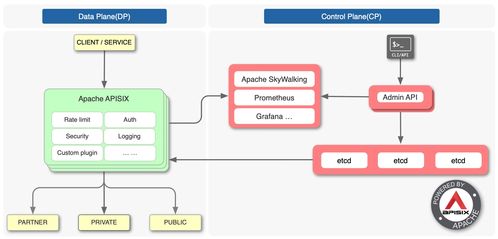

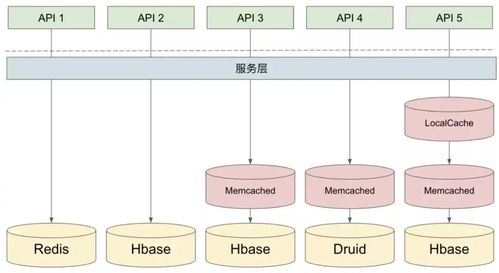

- 统一服务化与智能网关:将底层多样的数据能力(实时指标、用户标签、行为事件等)封装成标准的、高性能的API服务。通过构建统一的智能数据服务网关,实现服务的自动注册发现、负载均衡、熔断降级、监控告警以及统一的鉴权与流量治理。网关层面进行请求的智能路由与聚合,将多个数据点的查询合并,减少网络往返,进一步降低客户端感知延迟。

- 资源调度与稳定性保障:数据处理服务全面部署在云原生Kubernetes平台上,实现计算与存储资源的弹性伸缩。通过完善的监控体系(涵盖QPS、延迟、错误率、资源利用率等)和自动扩缩容策略,从容应对流量洪峰。建立了从数据链路血缘追踪到服务依赖治理的全链路可观测性体系,确保问题能够快速定位与恢复。

三、 关键优化与创新点

- 数据局部性优化:将计算任务尽可能调度到靠近存储节点的位置,并利用SSD与内存分级存储热数据,大幅减少数据网络传输开销。

- 向量化执行与编译优化:在查询引擎中广泛采用向量化处理与即时编译(JIT)技术,最大化利用现代CPU的并行处理能力。

- 异步化与全链路并行:从数据摄入、处理到服务响应,全链路采用异步非阻塞设计,避免线程阻塞,提高系统整体吞吐。

四、 成效与展望

通过上述实践,快手的数据处理服务成功支撑了平台核心业务的实时数据需求,在“618”、“春晚”等超大流量场景下保持了服务的坚如磐石。千万级QPS与毫秒级响应的实现,不仅提升了用户体验,更驱动了业务决策从“天级”向“秒级”的跨越。快手将继续探索基于新硬件(如持久内存、智能网卡)的加速、AI for Data系统的自治运维以及更智能的数据服务编排,推动数据中台向更实时、更智能、更易用的方向演进。

快手的数据处理服务建设实践表明,应对超大规模实时数据挑战,需要的是一个融合流批、统一服务、软硬协同、并具备极致弹性与稳定性的系统性工程,这为行业构建高性能数据中台提供了宝贵的参考范式。

如若转载,请注明出处:http://www.baolaiyaotong.com/product/44.html

更新时间:2026-02-27 04:44:38